في 13 مايو 2024، أطلقت OpenAI نموذج GPT-4o، وهو نموذج اللغة الكبير التالي والخليفة لـ GPT-4 Turbo. يوفر هذا النموذج المتطور قدرات فريدة لتحليل النصوص والصوت والصور ومقاطع الفيديو، وقد أدى إلى ثورة كبيرة في مجموعة متنوعة من تطبيقات الذكاء الاصطناعي. إقرء المقال لمعرفة المزيد عن Chat GPT-4o وقدراته وكيفية استخدامه.

جدول المحتويات

- ما هو Chat GPT-4o وماذا يفعل؟

- ما الذي يجعل Chat GPT-4o مختلفًا عن GPT-4 Turbo؟

- كيف يعمل Chat GPT-4o؟

- هل يعد Chat GPT-4o تغييرًا كبيرًا عن GPT-4 Turbo؟

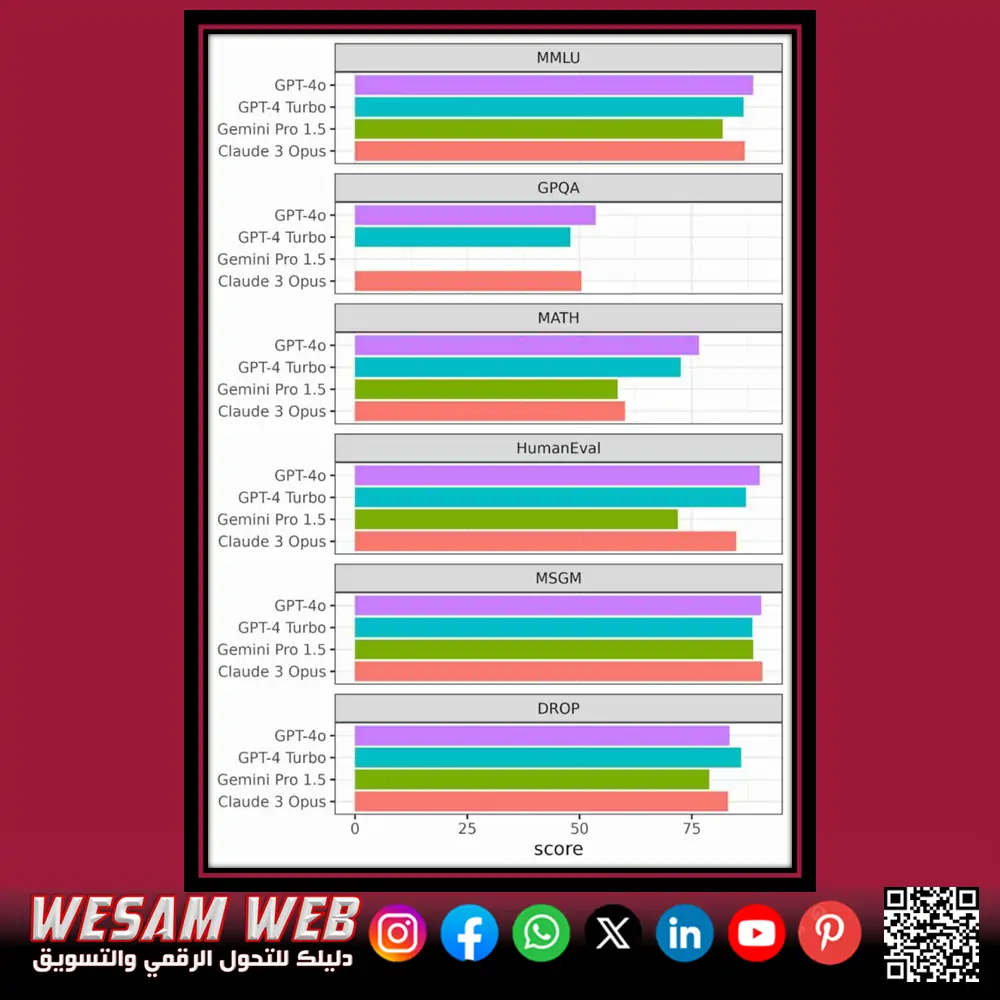

- أداء Chat GPT-4o مقارنة بالنماذج الأخرى

- 6 معايير مهمة

- ما هي استخدامات Chat GPT-4o؟

- ما هي القيود والمخاطر التي يفرضها Chat GPT-4o

- الفرق بين GPT-4o و GPT-3 و GPT 3.5 و GPT-4

- كم تكلفة Chat GPT-4o؟

- كيف يمكنني الوصول إلى Chat GPT-4o؟

- ماذا يحمل المستقبل لـ Chat GPT-4o؟

- الملخص

ما هو Chat GPT-4o وماذا يفعل؟

Chat GPT-4o هو أحدث نموذج لغة كبير (LLM) من OpenAI. يشير الحرف “o” في GPT-4o إلى omni، مما يشير إلى أن هذا النموذج الجديد يمكنه تلقي الأوامر التي تتضمن النص والصوت والصور والفيديو.

في السابق، استخدمت واجهة ChatGPT نماذج منفصلة لمعالجة أنواع مختلفة من المحتوى. على سبيل المثال، عندما تتحدث إلى المساعد الصوتي ChatGPT، يحول نظام التعرف التلقائي على الكلام Whisper صوتك إلى نص، ويولد GPT-4 Turbo استجابة نصية، ويحول TTS هذه الاستجابة النصية إلى كلام. تقارن الصورة أدناه بين كيفية تحليل GPT-4 Turbo وChat GPT-4o للمدخلات المنطوقة.

إن وجود نموذج واحد لمحتوى مختلف يزيد من سرعة وجودة النتائج، ويوفر واجهة مستخدم أبسط، ويتيح تطبيقات جديدة.

ما الذي يجعل Chat GPT-4o مختلفًا عن GPT-4 Turbo؟

يسمح نهج النموذج متعدد الأغراض لـ GPT-4o بالتغلب على القيود المختلفة لقدرات التفاعل الصوتي السابقة. القيود التي تمت مناقشتها هي كما يلي:

الانتباه إلى نبرة الصوت يمكّن من الاستجابات العاطفية

في نهج OpenAI السابق، والذي تضمن Whisper وGPT-4 Turbo وTTS في تشغيل واحد، لم يتمكن محرك الاستدلال، GPT-4، من الوصول إلا إلى الكلمات المنطوقة. وهذا يستلزم إهمال عوامل مثل نبرة الصوت والضوضاء الخلفية والتمييز بين الأصوات من العديد من المتحدثين؛ ونتيجة لذلك، لم يتمكن GPT-4 Turbo من توصيل الردود بمشاعر أو أنماط تحدث متنوعة.

باستخدام نموذج واحد يمكنه الاستدلال على النص والكلام، يمكن استغلال بيانات الصوت الغنية هذه لإنتاج ردود ذات جودة أعلى في نطاق أوسع من أنماط التحدث.

يتيح تقليل زمن الانتقال إجراء محادثات في الوقت الفعلي

أدى خط الأنابيب الحالي المكون من ثلاثة نماذج (Whisper وGPT-4 وTTS) إلى تأخير طفيف بين الدردشة باستخدام ChatGPT والحصول على استجابة. وفقًا لـ OpenAI، يبلغ متوسط زمن الانتقال لوضع الكلام 2.8 ثانية لـ GPT-3.5 و5.4 ثانية لـ GPT-4؛ ومع ذلك، يبلغ متوسط زمن الانتقال في Chat GPT-4o 0.32 ثانية، وهو أسرع بـ 9 مرات من GPT-3.5 وأسرع بـ 17 مرة من GPT-4.

يضاهي هذا التخفيض في زمن الانتقال وقت رد الفعل البشري النموذجي (0.21 ثانية) وهو أمر بالغ الأهمية لتطبيقات المحادثة مثل الترجمة في الوقت الفعلي، حيث يكون الوقت بين الردود أمرًا حيويًا.

تمكن Unified insight من وصف مدخلات الكاميرا

بالإضافة إلى الصوت والنص، يمكن لـ GPT-4o معالجة الصور ومقاطع الفيديو. وهذا يعني أنه إذا سمحت له بالوصول إلى شاشة الكمبيوتر الخاصة بك، فقد يشرح ما هو موجود عليها، ويجيب على أسئلة تتعلق بالصورة على الشاشة، أو يعمل كصديق عمل لك.

لإثبات هذه القدرة، أنتجت OpenAI مقطع فيديو يظهر فيه سال خان من أكاديمية خان، حيث يساعد جي بي تي-4 أو ابن سال في أداء الواجبات المنزلية الحسابية. وبصرف النظر عن التفاعل مع الشاشة، فإن منح Chat GPT-4o حق الوصول إلى الكاميرا، مثل كاميرا الهاتف الذكي، يسمح له بوصف ما يراه.

الترميز الأفضل للأبجديات غير الرومانية: تسريع وفعالية من حيث التكلفة

يعد ترميز النص الفوري إحدى مراحل إجراء LLM. هذه وحدات نصية يفهمها النموذج. في اللغة الإنجليزية، غالبًا ما يكون الرمز كلمة أو جزء من كلمة. في المتوسط، تتطلب ثلاث كلمات إنجليزية أربعة رموز.

يتضمن GPT-4o نموذج ترميز محسنًا، مما يقلل من عدد الرموز المطلوبة لكل جملة. هذا المكسب مهم لأن نماذج اللغة غالبًا ما يتم إنشاؤها وتحسينها للأحرف الرومانية. بفضل تحسين عملية تقسيم الرموز للأحرف غير الرومانية مثل العربية والصينية والهندية، يمكن لهذه النماذج تحليل إدخال النص بشكل أكثر فعالية وباستخدام رموز أقل.

يعني العدد المنخفض من الرموز المطلوبة لمعالجة النص أن هناك حاجة إلى موارد أقل لتشغيل النموذج، مما يعزز سرعة إنشاء النص ويخفض التكاليف المرتبطة باستخدام واجهات برمجة تطبيقات معالجة اللغة الطبيعية، حيث يتم إصدار فواتير للعديد من هذه الخدمات بناءً على عدد الرموز المستهلكة.

خطة مجانية متاحة

وفقًا لسياسات التسعير الحالية لشركة OpenAI لـ ChatGPT، كان الوصول إلى النماذج الأكثر تقدمًا، مثل GPT-4 Turbo، مقتصرًا على خطط Plus وEnterprise المدفوعة، ولكن هذا يتغير؛ فقد قالت OpenAI إنها ستشمل أيضًا GPT-4o في الخطة المجانية. يمكن لمستخدمي خطة Plus إرسال خمسة أضعاف عدد المطالبات مقارنة بالمستخدمين المجانيين.

كيف يعمل Chat GPT-4o؟

لا تزال التفاصيل حول كيفية عمل Chat GPT-4o نادرة. التفصيل الوحيد الذي كشفت عنه OpenAI في إعلانها هو أن Chat GPT-4o عبارة عن شبكة عصبية واحدة مدربة على النص والصورة والمدخلات الصوتية. يختلف هذا النهج الجديد عن التقنيات السابقة التي تضمنت تدريب نماذج منفصلة على أنواع مختلفة من البيانات.

ومع ذلك، فإن جي بي تي-4 أو ليس النموذج الأول الذي يستخدم نهجًا متعدد الوسائط. في عام 2022، أنشأت TenCent Labs نموذجًا يسمى SkillNet يجمع بين ميزات محول LLM وتقنيات الرؤية الحاسوبية لتحسين قدرته على التعرف على الأحرف الصينية.

في عام 2023، أنشأ فريق من ETH Zurich وMIT وجامعة ستانفورد WhisBERT، وهو أحد أشكال عائلة BERT من نماذج اللغة الكبيرة. على الرغم من أنه ليس الأول، إلا أن GPT-4o أكثر إثارة للإعجاب وقوة من الجهود السابقة.

هل يعد Chat GPT-4o تغييرًا كبيرًا عن GPT-4 Turbo؟

يعتمد الحكم على مدى التغيير الذي أحدثته بنية Chat GPT-4o مقارنة بـ GPT-4 Turbo على ما إذا كنت تنظر إليها من منظور فريق الهندسة أو التسويق في OpenAI. في أبريل، تنافس روبوت يُدعى im-also-a-good-gpt2-chatbot في مسابقة Chatbot Arena التابعة لـ LMSYS، والتي صُممت لقياس أفضل الذكاء الاصطناعي التوليدي. والآن، اتضح أن الروبوت الغامض كان Chat GPT-4o.

يشير gpt2 في اسم الروبوت إلى تغيير كبير في بنية عائلة نموذج GPT، ولا ينبغي الخلط بينه وبين GPT-2، الذي سبق GPT-3.5 وGPT-4.

من المؤكد أن البعض في فريق البحث والهندسة في OpenAI يعتقدون أن دمج أنواع المحتوى النصي والصورة والصوت في نموذج واحد هو تغيير كبير يستحق أول إصدار رئيسي له منذ ست سنوات؛ وبدلاً من ذلك، قرر فريق التسويق تنفيذ تغيير أكثر حذرًا في الاسم والاستمرار في اتباع اتفاقية تسمية GPT-4.

أداء Chat GPT-4o مقارنة بالنماذج الأخرى

قدمت OpenAI نتائج معيارية لـ Chat GPT-4o مقارنة بالعديد من النماذج الأخرى المتميزة، بما في ذلك GPT-4 Turbo وGPT-4 وClaude 3 Opus وGemini Pro 1.5 وGemini Ultra 1.0 وLlama 3 400B.

ثلاثة فقط من هذه النماذج قابلة للمقارنة حقًا. على مدار الأشهر القليلة الماضية، كافح GPT 4 Turbo وClaude 3 Opus وGemini Pro 1.5 للوصول إلى قمة تصنيفات LMSYS Chatbot Arena. قد يكون Llama 3 400B منافسًا قويًا في المستقبل، لكن الأمر لم ينته بعد، وبالتالي تم عرض فقط نتائج هذه النماذج الثلاثة وجي بي تي-4 أو.

6 معايير مهمة

المعايير لمقارنة نماذج اللغة المختلفة هي كما يلي:

فهم اللغة متعدد المهام على نطاق واسع (Massive Multitask Language Understanding)

المهام في الرياضيات الابتدائية والتاريخ الأمريكي وعلوم الكمبيوتر والقانون والمزيد هي معايير. لتحقيق دقة عالية في هذا الاختبار، يجب أن يكون لدى النماذج معرفة واسعة بالعالم ومهارات حل المشكلات.

أسئلة وأجوبة على مستوى الدراسات العليا من جوجل (Graduate-Level Google-Proof Q&A)

هذه الأسئلة كتبها خبراء في مجالات الأحياء والفيزياء والكيمياء. الأسئلة عالية الجودة وصعبة للغاية، والخبراء الحاصلون على درجة الدكتوراه أو الذين يدرسون في هذه المجالات لا يمكنهم تحقيق أكثر من 74 نقطة من الدقة. هذه الأسئلة مضادة لبحث Google.

MATH

تتكون مشاكل الرياضيات في المدارس الثانوية والمتوسطة من هذا الجزء من المقارنة.

HumanEval

اختبار للتحقق من صحة الكود الحاسوبي الوظيفي المستخدم للتحقق من إنشاء الكود.

رياضيات المدرسة الابتدائية متعددة اللغات (Multilingual Grade School Math)

تتم ترجمة مشاكل الرياضيات في المدارس الابتدائية إلى 10 لغات، بما في ذلك اللغات غير الممثلة مثل البنغالية والسواحيلية.

الاستدلال المنفصل على الفقرات (DROP)

تتكون الأسئلة التي تتطلب فهمًا شاملاً للفقرات من هذا القسم، على سبيل المثال، عن طريق إضافة أو عد أو فرز القيم المنتشرة عبر جمل متعددة.

أداء Chat GPT-4o وGPT-4 Turbo وGemini Pro 1.5 وClaude 3 Opus مقارنة بستة معايير LLM. تتراوح الدرجات لكل معيار من صفر إلى مائة. يتم إعادة بناء هذه النتائج من البيانات المقدمة من OpenAI. لا يتم توفير بيانات معيار GPQA لـ Gemini Pro 1.5.

سجل Chat GPT-4o أفضل نتيجة في أربعة معايير؛ ومع ذلك، فقد تفوق عليه Claude 3 Opus في معيار MSGM وفي معيار DROP بواسطة GPT-4 Turbo. بشكل عام، هذا أداء مثير للإعجاب وعلامة واعدة على نهج التدريب متعدد الحالات الجديد.

إذا نظرت عن كثب إلى أداء جي بي تي-4 أو مقارنة بـ GPT-4 Turbo، فسترى أن زيادة الأداء لا تتجاوز بضعة في المائة. هذا تحسن كبير على مدار عام، لكنه ليس كبيرًا مثل القفزات من GPT-1 إلى GPT-2 أو من GPT-2 إلى GPT-3.

ما هي استخدامات Chat GPT-4o؟

يتمتع GPT-4o بمجموعة متنوعة من الاستخدامات ويمكنه المساعدة في أي مجال تحتاجه. لقد ذكرنا بعض استخداماته هنا.

Chat GPT-4o لتحليل البيانات ومهام الترميز

أصبحت نماذج GPT الحديثة ومشتقاتها، مثل GitHub Copilot، قادرة الآن على تقديم المساعدة في الترميز و تحليل البيانات، بما في ذلك كتابة التعليمات البرمجية وشرح الأخطاء وإصلاحها. تفتح قدرات Chat GPT-4o متعددة الأوضاع بعض الفرص المثيرة للاهتمام.

في مقطع فيديو ترويجي استضافته المديرة التقنية لشركة OpenAI ميرا موراتي، استخدم باحثان من OpenAI، مارك تشين وبريت زوف، GPT-4o للعمل مع تعليمات Python البرمجية. تمت مشاركة التعليمات البرمجية مع GPT كنص، وتم استخدام ميزة التفاعل الصوتي لشرح التعليمات البرمجية بواسطة GPT. بعد تنفيذ التعليمات البرمجية، تم استخدام القدرات المرئية لـ جي بي تي-4 أو لشرح الرسم البياني.

بشكل عام، فإن عرض شاشتك على ChatGPT والتحدث إليها عملية أبسط كثيرًا من حفظ مخطط كملف صورة، وتحميله إلى ChatGPT، ثم كتابة سؤال.

الترجمة في الوقت الفعلي

يمكنك اصطحاب GPT-4o معك في رحلاتك كمترجم. تعني قدرات الكلام منخفضة الكمون في GPT-4o أن الترجمة في الوقت الفعلي أصبحت ممكنة الآن، مما يجعل السفر إلى البلدان التي لا تتحدث لغتها أسهل كثيرًا.

لعب الأدوار مع GPT 4o

كان ChatGPT أداة مفيدة للعب الأدوار في مجموعة متنوعة من السيناريوهات. سواء كنت تستعد لمقابلة عمل لوظيفة أحلامك أو تدرب فريق المبيعات الخاص بك لبيع منتجك بشكل أفضل، فقد كان هذا الروبوت الدردشة موجودًا من أجلك، ولكن الآن مع تحسين قدرات الرؤية والكلام، وصل لعب الأدوار هذا إلى مستوى غير مسبوق ومذهل.

الدردشة مع شات جي بي تي 4o ومساعدة المستخدمين المكفوفين

قد تكون قدرة جي بي تي-4 أو على فهم مدخلات الفيديو من الكاميرا ووصف المشهد شفهيًا ميزة مهمة للمكفوفين. إنها ميزة الوصف الصوتي التي تجدها على أجهزة التلفاز، ولكن في الحياة الواقعية.

ما هي القيود والمخاطر التي يفرضها Chat GPT-4o

لا تزال اللوائح الخاصة بالذكاء الاصطناعي التوليدي في مراحلها المبكرة؛ ويُعَد قانون الذكاء الاصطناعي في الاتحاد الأوروبي الإطار القانوني الوحيد المهم في الوقت الحالي؛ وهذا يعني أن شركات الذكاء الاصطناعي سوف تضطر إلى اتخاذ بعض قراراتها الخاصة بشأن ما يشكل الذكاء الاصطناعي الآمن. تمتلك OpenAI إطار عمل للاستعداد تستخدمه لتحديد ما إذا كان النموذج الجديد جاهزًا للطرح للجمهور.

يفحص الإطار أربعة مجالات مثيرة للقلق:

- الأمن السيبراني: هل يمكن للذكاء الاصطناعي زيادة إنتاجية مجرمي الإنترنت والمساعدة في خلق نقاط ضعف؟

- التهديدات البيولوجية والكيميائية والإشعاعية والنووية (BCRN): هل يمكن للذكاء الاصطناعي مساعدة الخبراء في تحديد التهديدات البيولوجية أو الكيميائية أو الإشعاعية أو النووية؟

- الإقناع: هل يمكن للذكاء الاصطناعي إنشاء محتوى تفاعلي يقنع الناس بتغيير معتقداتهم؟

- استقلالية النموذج: هل يمكن للذكاء الاصطناعي أن يعمل كوكيل ويتخذ إجراءات مع برامج أخرى؟

يتم تصنيف كل مجال من مجالات القلق على أنه منخفض أو متوسط أو مرتفع أو حرج، حيث تكون درجة النموذج هي الأعلى من الفئات الأربع.

وعدت شركة OpenAI بعدم إصدار نموذج بمستوى قلق حرج؛ بالطبع، هذا ليس واضحًا وله معيار أمان ضعيف نسبيًا، لكن هذا هو كلام شركة OpenAI! وفقًا لتعريفات شركة OpenAI، فإن القلق الحرج هو شيء من شأنه أن يعطل الحضارة البشرية، ويعتبر GPT-4o نموذجًا آمنًا بدرجة قلق متوسطة.

مخرجات غير كاملة

مثل جميع الذكاء الاصطناعي التوليدي، لا يعمل هذا النموذج دائمًا كما هو متوقع. الرؤية الحاسوبية ليست مثالية، لذا فإن تفسيراتها للصورة أو الفيديو ليست مضمونة الدقة؛ ونادرًا ما يكون التعرف على إدخال الصوت دقيقًا بنسبة 100%، وقد يكون مضللًا إذا كان المتحدث لهجة قوية أو يستخدم مصطلحات تقنية. قدمت OpenAI مقطع فيديو لبعض الأخطاء التي ارتكبها جي بي تي-4 أو.

على وجه الخصوص، كانت الترجمة بين لغتين غير الإنجليزية واحدة من الحالات التي فشلت فيها، مع أسباب مثل التنغيم غير المناسب والتحدث باللغة الخاطئة التي ساهمت أيضًا.

مخاطر الاحتيال الصوتي المتسارعة

يشير إعلان OpenAI إلى أننا “نعترف بأن أوضاع صوت الدردشة في GPT-4o تقدم أنواعًا جديدة من المخاطر”. في العديد من السياقات، يمكن أن تؤدي الدردشة في GPT-4o إلى زيادة المكالمات المزيفة والاحتيال. هذه مشكلة ستزداد سوءًا قبل أن تتحسن، ولدي Chat GPT-4o القدرة على جعل المكالمات المزيفة أكثر إقناعًا. لتخفيف هذا الخطر، يتوفر إخراج الصوت فقط بمجموعة من الأصوات المحددة مسبقًا.

الفرق بين GPT-4o و GPT-3 و GPT 3.5 و GPT-4

| الميزة/المعيار | GPT-3 | GPT-3.5 | GPT-4 | GPT-4o |

|---|---|---|---|---|

| السرعة (متوسط التأخير) | 2.8 ثانية | 2.8 ثانية | 5.4 ثانية | 0.32 ثانية (9x أسرع من GPT-3.5) |

| عدد المعلمات (Parameters) | حوالي 175 مليار | حوالي 175 مليار | أكثر من 175 مليار (غير محدد بالضبط) | محسّن وأكثر كفاءة بتقليل الحجم |

| جودة الإجابات | جيدة ومبسطة | أكثر دقة وسرعة | دقيقة للغاية مع القدرة على السياق المعقد | دقيقة وسريعة بنفس الوقت |

| التكلفة | أقل تكلفة | تكلفة معتدلة | أعلى تكلفة مقارنة بالأخرى | أقل تكلفة مع تحسين الأداء |

| التطبيقات | كتابة النصوص، الأبحاث المبسطة | تحسين الكتابة، دعم البرمجة | الأبحاث المعقدة، السياق المتقدم | ترجمة فورية، الوقت الحقيقي |

| الاستخدام في الصوتيات | غير مدعوم | مدعوم بصوتيات بسيطة | دعم محسّن للصوتيات | دعم كامل مع تأخير منخفض |

| اللغات المدعومة | يدعم لغات متعددة | يدعم لغات متعددة | يدعم لغات أكثر مع تحسين الفهم | أداء أكثر كفاءة في جميع اللغات |

| كفاءة الذكاء الاصطناعي | أساسية | متقدمة | متقدمة للغاية | متقدمة جدًا + سرعة |

| الواقعية في المحادثة | محدود في المحادثات الطويلة | جيد في المحادثات | ممتاز في السياق المطوّل | ممتاز وسريع في الزمن الحقيقي |

كم تكلفة Chat GPT-4o؟

على الرغم من كونه أسرع من GPT-4 Turbo ويقدم قدرات تصور أفضل، فإن GPT-4o أرخص بنحو 50% من سابقه. وفقًا لموقع OpenAI على الويب، يكلف النموذج 5 دولارات لكل مليون رمز إدخال و15 دولارًا لكل مليون رمز إخراج.

كيف يمكنني الوصول إلى Chat GPT-4o؟

لقد تغيرت واجهة مستخدم ChatGPT، ويعتمد جميع المستخدمين افتراضيًا على Chat GPT-4o، ولكن يمكن تغيير النموذج إلى GPT-3.5 أو GPT-4 باستخدام مفتاح.

ماذا يحمل المستقبل لـ Chat GPT-4o؟

هناك وجهتا نظر مختلفتان بشأن الاتجاه المستقبلي للذكاء الاصطناعي. وجهة النظر الأولى هي أن الذكاء الاصطناعي يحتاج إلى أن يصبح أكثر قوة وقدرة على أداء مجموعة أوسع من المهام. وجهة النظر الأخرى هي أن الذكاء الاصطناعي يحتاج إلى أن يصبح أفضل في حل مهام محددة بتكلفة أقل.

تقع مهمة OpenAI لإنشاء الذكاء الاصطناعي العام (AGI) ونموذج أعمالها في الفئة الأولى. GPT-4o هي خطوة أخرى نحو جعل الذكاء الاصطناعي أكثر قوة. هذا النموذج جديد تمامًا لشركة OpenAI، مما يعني أن الشركة ستقدم الكثير من الميزات للتعلم والتحسين في الأشهر المقبلة.

على المدى القصير، يمكننا أن نتوقع مشاكل وأوهامًا جديدة، وعلى المدى الطويل، يمكننا أن نتوقع تحسينات من حيث السرعة وجودة الإنتاج.

إن توقيت إصدار Chat GPT-4o مثير للاهتمام. فعندما أدركت شركات التكنولوجيا العملاقة أن Siri وAlexa وGoogle Assistant ليست أدوات مربحة كما كانت تأمل، تأمل OpenAI في جعل الذكاء الاصطناعي يتحدث مرة أخرى. وفي أفضل الأحوال، سيفتح هذا حالات استخدام جديدة للذكاء الاصطناعي التوليدي.

الملخص

يمثل GPT-4o تقدمًا إضافيًا في الذكاء الاصطناعي التوليدي، حيث يجمع بين معالجة النص والصوت والصور في نموذج واحد فعال. ويعد الابتكار باستجابات أسرع وتفاعلات أكثر ثراءً ومجموعة أوسع من التطبيقات، من الترجمة في الوقت الفعلي إلى تحليلات البيانات المتقدمة وتحسين إمكانية الوصول للأشخاص ذوي الإعاقات البصرية.

ورغم وجود قيود ومخاطر مبكرة، مثل سوء الاستخدام في عمليات الاحتيال باستخدام تقنية التزييف العميق والحاجة إلى مزيد من التحسين، فإن جي بي تي-4 أو يمثل خطوة أخرى نحو هدف OpenAI المتمثل في تحقيق الذكاء الاصطناعي العام. ومع تزايد إمكانية الوصول إلى هذا النموذج، يمكن أن يغير GPT-4o الطريقة التي نتفاعل بها مع الذكاء الاصطناعي وندمجه في المهام اليومية والمهنية. إن مستقبل الذكاء الاصطناعي مثير، والآن هو الوقت المناسب للبدء في تعلم كيفية عمل هذه التكنولوجيا.